Una parola chiave che sta diventando recentemente popolare nel mondo della ricerca sulle interfacce per dispositivi mobili è eyes-free interface, ovverosia un’interfaccia che possa essere usata senza la necessità di guardare il display del cellulare.

Una parola chiave che sta diventando recentemente popolare nel mondo della ricerca sulle interfacce per dispositivi mobili è eyes-free interface, ovverosia un’interfaccia che possa essere usata senza la necessità di guardare il display del cellulare.

C’e’ una categoria di utenti, i non vedenti, per la quale ll’interfaccia eyes-free è l’unica strada percorribile: interessante in tal senso l’iniziativa di Google per dotare il suo Android di un’interfaccia eyes-free.

Per gli utenti vedenti, l’uso di interfacce eyes-free viene invece motivato con il fatto che le persone usano i telefonini mentre fanno altre cose (purtroppo anche pericolose, come guidare un veicolo) e quindi l’interfaccia eyes-free viene proposta come una soluzione che libera la vista dell’utente per permettergli di concentrarla su queste altre attività. Dietro questa motivazione si cela però un’aspettativa eccessiva.

Questo è uno dei temi su cui mi hanno invitato a tenere il keynote speech dell’evento internazionale sulle interfacce multimodali svoltosi la scorsa settimana al Fraunhofer Institute in Germania. In estrema sintesi, mentre un’interfaccia eyes-free può essere perfetta per compiti semplici (descrivo un esempio originale alla fine del post), quando il compito da svolgere diventa complesso e ricco di contenuti informativi, l’approccio eyes-free rischia invece di essere inefficace o addiruttura controproducente.

Per le persone vedenti, infatti, la vista è il senso dominante (almeno il 70% delle informazioni che acquisiscono dall’ambiente esterno arriva attraverso gli occhi): mantenere il contenuto informativo inalterato senza usare gli occhi significa spostare l’acquisizione di quelle informazioni verso il senso dell’udito (auditory interface) e/o del tatto (haptic interface).

Ad esempio, provate ad immaginarvi di stare camminando per strada ed il vostro telefonino vi legge con una voce sintetica un menu di 12 voci oppure una pagina web in auricolare e vi chiede quale link volete selezionare, facendovi ad esempio pronunciare il numero corrispondente attraverso il microfono. Nonostante i vostri occhi guardino la strada, quanto vi assorbirebbe mentalmente seguire il filo informativo e ricordare tutte le informazioni necessarie per fare le vostre scelte?

E’ un problema che è già stato studiato per le interfacce destinate alle automobili ed i ricercatori che si lanciano su questo nuovo trend dei telefoni eyes-free rischiano di riscoprire l’acqua calda. Del caso automobilistico avevo scritto in precedenza: in quel settore è ormai chiaro che per garantire che il guidatore non venga distratto dal suo compito primario è necessario tener libero non solo il suo sguardo, ma anche la sua mente .

Un’interfaccia eyes-free rischia di impegnare la mente molto di più di un’interfaccia che richiede degli sguardi occasionali ad un display. Quindi il tema vero su cui focalizzarsi per costruire interfacce migliori destinate agli utenti mobili vedenti non è “occhi sì, occhi no”, ma “quanta attenzione richiede l’interfaccia all’utente?” e l’obbiettivo è di minimizzare l’attenzione ed il carico mentale richiesti per un uso efficace dell’applicazione.

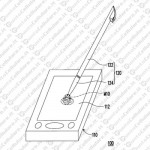

Ma come dicevo in apertura, se il compito da svolgere è semplice e coinvolge poche informazioni, allora possono esserci delle soluzioni eyes-free anche simpatiche. Un esempio è lo Shoogle (v. fotografia sopra), un software sperimentale che fornisce all’utente alcune informazioni sullo stato del telefonino, semplicemente agitandolo.

Le informazioni principali riguardano la presenza di SMS, il loro numero e dimensioni e la categoria di utente che li ha inviati. Queste informazioni vengono tradotte in suoni ed in sensazioni tattili. La metafora è quella di un barattolo contenente delle biglie: ogni SMS è una biglia ed il peso della biglia dipende dalla lunghezza del messaggio, il materiale di cui è fatta la biglia dipende dalla tipologia di mittente.

Ad esempio, se agitiamo il telefonino tenendolo in tasca e sentiamo con le orecchie un suono distintamente metallico e con il tatto singoli colpi profondi, allora c’e’ un lungo SMS proveniente da un collega di lavoro. Se sentiamo diversi piccoli urti e con un suono simile al vetro, ci sono diversi brevi messaggi provenienti da amici. Per chi ci guarda da fuori, l’impressione è che stiamo brevemente scuotendo qualcosa come un mazzo di chiavi tenuto in tasca.

Oppure, se vogliamo parlare con un linguaggio da tecnici, stiamo usufruendo di un’interfaccia multimodale che fa information sonification ed information haptification.

Fonte: lucachittaro.nova100.ilsole24ore.com